Einleitung

Die im Jahr 2024 verabschiedete KI-Verordnung (KI-VO) der Europäischen Union schafft erstmals einen umfassenden Rechtsrahmen für den Einsatz von künstlicher Intelligenz. Die KI-Verordnung schafft Rechtssicherheit für Unternehmen, die KI einsetzen und entwickeln, aber auch Schutz für die Grundrechte der Bürgerinnen und Bürger.

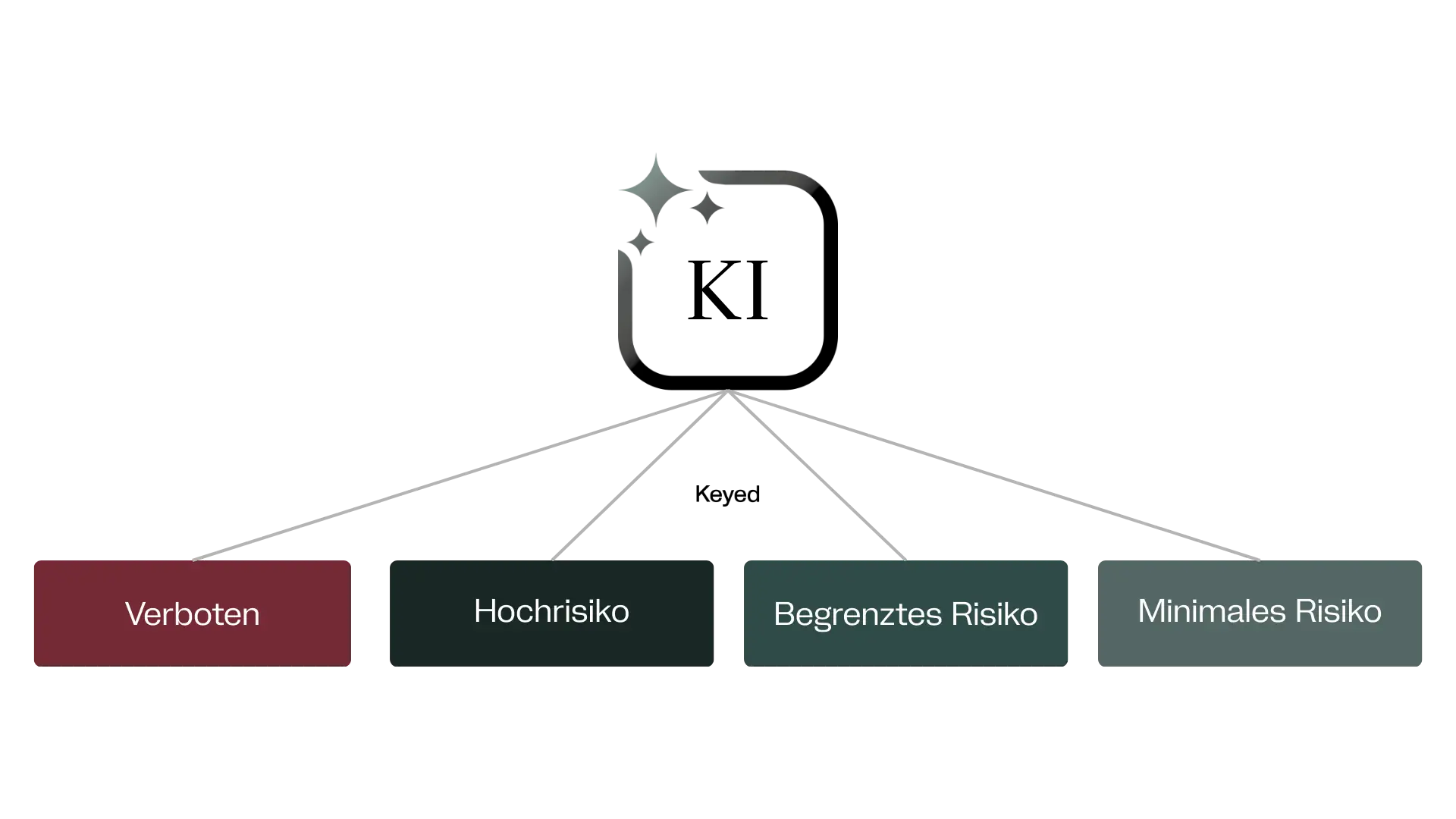

Die KI-Verordnung verfolgt einen risikobasierten Ansatz. KI-Systeme werden in vier Gefährdungsklassen: verbotene, hochriskante, begrenzt riskante und risikoarme KI-Systeme. Dieser Blogbeitrag wird sich dem Prozess der Risikoklassifizierung widmen und den Ablauf sowie die wesentlichen Kriterien erläutern.

Mehr Informationen zum Anwendungsbereich und zu den Pflichten aus der KI-Verordnung finden Sie in unserem Blogbeitrag zur KI-Verordnung im Kontext der DSGVO.

Was ist die Risikoklassifizierung für KI?

Die Risikoklassifizierung der KI-Systeme ist für Unternehmen von hoher Bedeutung, denn je nach Klassifizierung müssen unterschiedliche Anforderungen erfüllt werden. Demnach ist nach der Inventarisierung der KI-Systeme die Risikoklassifizierung pro KI der nächste notwendige Schritt.

Nicht jede Anwendung künstlicher Intelligenz ist gleich gefährlich. Daher kategorisiert die KI-Verordnung Systeme in vier Klassen. Während SPAM-Filter oder KI-gestützte Videospiele kaum Risiko bergen, können KI-gestützte Überwachungssysteme und Social Scoring erhebliche Folgen für betroffene Personen und ihre Grundrechte darstellen.

Die vier Risikostufen der KI-VO

Die Verordnung folgt einem risikobasierten Ansatz und unterscheidet KI-Systeme je nach potenzieller Gefährdung in vier Kategorien.

Die KI-VO gilt nicht nur für europäische Unternehmen, sondern auch für Anbieter außerhalb der EU, sobald deren Systeme innerhalb der Union eingesetzt werden – ein extraterritorialer Anwendungsbereich, der bereits aus der DSGVO bekannt ist.

Unannehmbares Risiko (Art. 5 KI-VO)

KI-Systeme mit unannehmbarem Risiko sind in der EU verboten. Diese KI-Systeme sind mit den Werten der EU unvereinbar, da sie die Grundrechte systematisch verletzen. Beispiele sind manipulative KI, die unbemerkt Verhalten beeinflusst oder soziale Bewertungssysteme (Social Scoring).

Hochrisiko-KI (Art. 6 KI-VO)

Im Fokus der Verordnung liegen die KI-Systeme, die als hochriskant eingestuft werden. Für diese gibt es besonders strenge Vorschriften. Ein System gilt als „hochriskant“, wenn es wesentliche Grundrechte oder die Gesundheit und Sicherheit von Personen beeinträchtigen könnte. Hierunter fallen KI-Systeme, die in sensiblen Bereichen eingesetzt werden, wie in der kritischen Infrastruktur (z.B. Energie, Verkehr, Wasser), Medizinprodukte mit KI-Komponenten oder KI-Systeme für die Strafverfolgung. Für diese KI-Systeme macht die KI-VO besonders strenge Vorgaben.

Begrenztes Risiko (Art. 50 KI-VO)

Systeme mit begrenztem Risiko sind solche, die zwar nicht in sensible Rechte eingreifen, aber dennoch ein Risiko bergen. Darum gibt es für Betreibende besondere Transparenzpflichten. Beispielsweise müssen Chatbots klarstellen, dass man mit einer Maschine interagiert, oder KI-generierte Inhalte (Deepfakes) müssen klar als KI-generiert gekennzeichnet werden.

Minimales oder kein Risiko

KI-Systeme mit minimalem Risiko fallen nicht unter die Regelungen der Verordnung. Als Beispiele sind hier Spamfilter oder KI-gestützte Videospiele zu nennen. Hier gibt es keine speziellen Pflichten.

Bei KI-Systemen mit hohem Risiko sind daher strenge Pflichten und Zertifizierungen erforderlich, während bei KI-Systemen mit kleinem oder minimalem Risiko kaum regulatorische Eingriffe notwendig sind. Durch die klare Regelung soll Rechtssicherheit für neue Innovationen geschaffen werden.

Wie macht man eine Risikoklassifizierung für KI?

Doch wie läuft die Einordnung der KI-Systeme in eine der Risikoklassen in der Praxis ab?

Prüfung des Geltungsbereiches

Zunächst sollte geprüft werden, ob der Anwendungsbereich der KI-VO überhaupt für das infrage stehende System eröffnet ist. Folgende KI-Systeme unterliegen nicht der KI-VO:

- KI-Systeme, die ausschließlich für militärische Zwecke, Verteidigungszwecke und Zwecke der nationalen Sicherheit genutzt werden

- KI-Systeme, die nur für wissenschaftliche Forschung und Entwicklung genutzt werden

Für diese KI-Systeme muss keine Klassifizierung vorgenommen werden. Wichtig ist jedoch, dass die KI-Systeme ausschließlich für einen der genannten Zwecke genutzt werden. Dienen die KI-Systeme zusätzlich noch anderen Zwecken, dann kann der Anwendungsbereich eröffnet sein.

Detailprüfung der Anwendbarkeit

Handelt es sich weder um ein KI-System für militärische Zwecke noch um eins für wissenschaftliche Zwecke, muss mithilfe der Definition für KI-Systeme aus Art. 3 Abs. 1 KI-VO festgestellt werden, ob es sich um ein KI-System im Sinne der Verordnung handelt. Gemäß Art. 3 sind das: Systeme, die für einen in unterschiedlichem Grade autonomen Betrieb ausgelegt sind und die nach seiner Betriebsaufnahme anpassungsfähig sein können und die aus den erhaltenen Eingaben für explizite oder implizite Ziele ableiten, wie Ausgaben oder etwa Vorhersagen, Inhalte, Empfehlungen oder Entscheidungen erstellt werden, die physische oder virtuelle Umgebungen beeinflussen können.

Im zweiten Schritt müssen Sie sich also fragen:

- Ist das System maschinenbasiert (Hardware- und/oder Softwarekomponente)?

- Ist das System für den Betrieb mit unterschiedlichen Autonomiegraden konzipiert?

- Kann das System nach der Bereitstellung Anpassungsfähigkeit aufweisen?

- Ist das System für explizite oder implizite Ziele ausgelegt?

- Kann das System aus den empfangenen Daten Schlussfolgerungen ziehen?

- Ist das System in der Lage, aus den empfangenen Eingaben, Ausgaben wie Vorhersagen, Inhalte, Empfehlungen oder Entscheidungen zu erzeugen?

- Können diese Aussagen physische oder virtuelle Umgebungen beeinflussen?

Können sie alle diese Fragen mit „Ja“ beantworten, handelt es sich um ein KI-System im Sinne der Verordnung.

Prüfung auf verbotene KI

Im dritten Schritt der Risikoklassifizierung ist zu prüfen, ob es sich bei dem betrachteten KI-System um ein nach Art. 5 KI-VO verbotenes System handelt. Die Verordnung listet bestimmte Anwendungsfälle auf, die aufgrund ihres hohen Gefahrenpotenzials als unannehmbares Risiko gelten und daher grundsätzlich nicht eingesetzt werden dürfen.

Zunächst stellt sich die Frage, ob das System auf verdeckte oder manipulative Techniken zurückgreift, die das Verhalten von Personen unbemerkt beeinflussen sollen. Ebenfalls unzulässig sind Anwendungen, die gezielt die besondere Schutzbedürftigkeit einzelner Menschen ausnutzen – sei es aufgrund des Alters, einer Behinderung oder einer prekären sozialen oder wirtschaftlichen Situation. Auch Systeme, die über längere Zeiträume hinweg Bewertungen oder Einstufungen von Personen auf Grundlage ihres sozialen Verhaltens oder ihrer persönlichen Eigenschaften vornehmen, fallen in die Kategorie der verbotenen „Social Scoring“-Anwendungen. Verboten ist darüber hinaus der Einsatz von KI zur Emotionserkennung in Bildungseinrichtungen oder am Arbeitsplatz sowie der Einsatz zu Zwecken der biometrischen Kategorisierung.

Besondere Aufmerksamkeit verlangt die Nutzung von KI im Bereich der Strafverfolgung. Ein System, das ausschließlich dazu dient, vorherzusagen, ob eine bestimmte Person eine Straftat begehen wird, ist unzulässig. Anders verhält es sich, wenn die KI lediglich eine menschliche Bewertung unterstützt, die sich auf objektive, überprüfbare und tatbezogene Fakten stützt. Problematisch wird es auch dann, wenn eine Anwendung mit dem Ziel betrieben wird, umfassende Datenbanken zur Gesichtserkennung zu erstellen oder zu erweitern – auch dies ist nach der Verordnung ausdrücklich verboten.

Von diesem grundsätzlichen Verbot sieht die KI-Verordnung jedoch eng umrissene Ausnahmen vor. So dürfen bestimmte Formen der Echtzeit-Fernidentifizierung in öffentlich zugänglichen Räumen eingesetzt werden, wenn sie ausschließlich zu klar definierten Strafverfolgungszwecken dienen. Dies gilt etwa, wenn vermisste Personen oder Opfer von Entführung und Menschenhandel gesucht werden, wenn eine akute Gefahr für Leib und Leben oder ein terroristischer Anschlag abgewendet werden muss oder wenn es um die Identifizierung von Personen geht, die einer konkreten Straftat verdächtig sind, um Ermittlungen oder Strafverfahren zu ermöglichen.

Damit lässt sich die Prüfung zusammenfassen: Immer wenn eine der oben beschriebenen Anwendungen bejaht werden muss, liegt grundsätzlich ein verbotenes KI-System vor. Nur dann, wenn einer der ausdrücklich vorgesehenen Ausnahmefälle einschlägig ist, darf die Technologie dennoch eingesetzt werden.

Hochrisiko-KI Prüfung

Handelt es sich bei dem infrage stehenden KI-System nicht um eine verbotene KI, wird nun geprüft, ob es sich um ein System des Hochrisiko-Bereichs handelt. Die Bereiche sind im Anhang III der KI-VO aufgeführt.

Ein KI-System wird als Hochrisiko eingestuft, wenn es (1) Teil eines sicherheitsrelevanten Produkts ist, (2) in einem Hochrisiko-Anwendungsbereich nach Anhang III eingesetzt wird oder (3) automatisiertes Profiling betreibt – es sei denn, es fällt unter eine der eng definierten Ausnahmen des Art. 6 Abs. 3 KI-VO.

Fällt das KI-System in einen der folgenden Bereiche, wird es als Hochrisiko eingestuft:

- Biometrie: biometrische Fernidentifizierung, Kategorisierung oder Emotionserkennung

- Kritische Infrastrukturen: Verwaltung und Betrieb sicherheitsrelevanter Infrastrukturen (z. B. Energie, Verkehr, Wasser, digitale Netze)

- Bildung: Systeme, die über Zugang, Leistungsbewertung oder Prüfungen entscheiden

- Beschäftigung & Personalmanagement: z. B. Bewerberauswahl, Leistungsüberwachung, Beförderungsentscheidungen

- Wesentliche Dienste: Entscheidungen über Sozialleistungen, Kreditwürdigkeit, Versicherungen, Notrufmanagement

- Strafverfolgung: KI zur Beweisanalyse, Gefahreneinschätzung oder Ermittlungsunterstützung (ausgenommen verbotene Systeme)

- Migration, Asyl & Grenzkontrolle: Systeme zur Prüfung, Identifizierung oder Risikoanalyse

- Justiz & demokratische Prozesse: Unterstützung von Gerichten oder Beeinflussung demokratischer Entscheidungen (z. B. Wählerverhalten)

In bestimmten Konstellationen gilt das System nicht als Hochrisiko-KI, auch wenn es in einem Bereich nach Anhang III eingesetzt wird:

- Das KI-System übernimmt nur eine eng umrissene Verfahrensaufgabe ohne maßgeblichen Einfluss auf das Ergebnis.

- Es verbessert lediglich das Resultat einer bereits abgeschlossenen menschlichen Tätigkeit.

- Es erkennt Muster oder Abweichungen, ohne die menschliche Bewertung wesentlich zu beeinflussen.

- Es führt eine vorbereitende Aufgabe durch, ohne selbst die kritische Entscheidung zu treffen.

Wenn eine dieser Bedingungen erfüllt ist, handelt es sich nicht um ein Hochrisiko-KI-System. Wenn keine Ausnahme greift, gilt das System als Hochrisiko-KI.

Prüfung auf KI mit begrenztem Risiko

Handelt es sich weder um ein verbotenes KI-System noch um eines mit hohem Risiko, kann es sich um ein KI-System mit begrenztem Risiko handeln. Ist dies der Fall, müssen Anbieter und Betreiber Transparenzpflichten beachten.

Als Anbieter müssen Sie zunächst prüfen, ob Ihr KI-System zur direkten Interaktion mit natürlichen Personen bestimmt ist. Ist das der Fall, greifen Transparenzpflichten nach Art. 50 Abs. 1 KI-VO, es sei denn, Ihr System ist gesetzlich ausdrücklich zur Aufdeckung, Verhütung, Ermittlung oder Verfolgung von Straftaten zugelassen oder steht der Öffentlichkeit ausschließlich zur Anzeige einer Straftat zur Verfügung. In diesen Sonderfällen gelten die Transparenzanforderungen nicht.

Ist Ihr KI-System dagegen nicht auf direkte Interaktion mit Menschen ausgerichtet, bestehen insoweit keine Transparenzpflichten.

Ein zweiter Prüfungsschritt betrifft die Frage, ob Ihr System synthetische Inhalte erzeugt – etwa Audio, Video, Bilder oder Texte. Ist das der Fall, müssen Sie grundsätzlich nach Art. 50 Abs. 2 KI-VO offenlegen, dass die Inhalte KI-generiert sind. Ausnahmen gelten, wenn Ihr System nur einfache Standardbearbeitung leistet, die Eingabedaten nicht wesentlich verändert oder wenn es wiederum gesetzlich für Strafverfolgungszwecke zugelassen ist. In diesen Fällen entfällt die Transparenzpflicht.

Damit ergibt sich: Anbieter müssen sich immer fragen, ob ihr System Menschen direkt adressiert oder synthetische Inhalte erzeugt – nur dann entstehen konkrete Transparenzanforderungen.

Als Betreiber sind vor allem zwei Szenarien relevant: biometrische Anwendungen und Deepfakes bzw. KI-generierte Inhalte.

Zunächst ist zu prüfen, ob Ihr System ein Emotionserkennungs- oder biometrisches Kategorisierungssystem ist. In diesem Fall müssen Sie nach Art. 50 Abs. 3 KI-VO Transparenz gewährleisten, es sei denn, das System ist gesetzlich für Zwecke der Strafverfolgung zugelassen, wird im Einklang mit dem Unionsrecht eingesetzt und es bestehen hinreichende Schutzvorkehrungen. Trifft dies zu, entfällt die Pflicht.

Weiterhin besteht eine Transparenzanforderung nach Art. 50 Abs. 4 KI-VO, wenn Ihr System Deepfakes erzeugt oder manipulierte Bild-, Ton- oder Videoinhalte erstellt. Nutzer müssen klar erkennbar informiert werden, dass es sich um künstlich erzeugte Inhalte handelt. Eine Ausnahme gibt es nur dann, wenn der Inhalt offensichtlich Teil eines künstlerischen, satirischen, fiktionalen oder ähnlichen Werks ist. Hier reicht es, dass der Kontext den künstlichen Charakter bereits erkennbar macht.

Für KI-generierte Texte gilt: Wenn diese öffentlich zugänglich gemacht werden, um über Angelegenheiten von öffentlichem Interesse zu informieren, besteht eine Transparenzpflicht. Die Pflicht entfällt nur dann, wenn entweder (1) die Inhalte einer menschlichen redaktionellen Kontrolle unterzogen werden und eine natürliche oder juristische Person die Verantwortung trägt, oder (2) das System gesetzlich für Strafverfolgungszwecke zugelassen ist.

Fällt Ihr KI-System in die vierte Kategorie, KI-Systeme mit minimalem Risiko, müssen sie keine Auflagen aus der KI-VO beachten.

Fazit

Die Risikoklassifizierung ist das Herzstück der neuen KI-VO. Sie sorgt dafür, dass da, wo KI-Systeme besonders tief in Grundrechte und sicherheitsrelevante Bereiche eingreifen, besonders strenge Anforderungen gelten. Für Unternehmen bedeutet das, dass sie ihre KI-Systeme kritisch prüfen sollten und Risiken sowie Einsatzbereiche dokumentieren müssen.